«Тот, кто владеет информацией, владеет миром». Похоже, никогда еще эта фраза не звучала так верно, как сегодня. Во втором десятилетии 21 века информация стала не только сырьем, инструментом и оружием, но также самым главным активом, за обладание которым сражаются корпорации и правительства. Об этом мы сегодня и поговорим.

В современной деловой среде распоряжение данными является важнейшим показателем успеха предприятия. Многие компании начали осознавать важность навыков использования информации. Сегодня так называемые «большие данные» — это важнейший тренд, который распространяется на самые разные направления бизнеса и технологий.

Термин «Большие данные» (Big data) используется для обозначения инициатив и технологий, которые включают в себя разнообразные и стремительно увеличивающиеся активы данных самых разных категорий. Многообразие этой информации осложняет их обработку, и те, кому удается это делать на благо своего бизнеса, относятся сегодня к числу успешных.

Big Data предполагает создание больших объемов сложных данных, их хранение, извлечение и анализ. Дисциплина «большие данные» основывается на принципе трех V — Volume (объем), Velocity (скорость) и Variety (многообразие).

Объем. Двадцать лет назад обычный компьютер имел жесткий диск со средним объемом 10 гигабайт. Сегодня социальные платформы, такие как Facebook, ежедневно обрабатывают более полмиллиарда терабайт данных. Воздушные суда Boeing генерируют сотни терабайт летных данных за один-единственный рейс. Широкое использование смартфонов и планшетов обеспечивает выработку миллиардов терабайт постоянно обновляющейся информации, которая является такой же пестрой и разнообразной, как и наш мир.

Скорость. Системы учета кликов в Интернете каждую секунду анализируют миллионы действий пользователей Сети. Изменения в состоянии торгов на фондовых биржах обновляются в течение микросекунд. Игровые серверы могут поддерживать единовременное подключение миллионов пользователей, которые за каждую секунду осуществляют множество действий. Это только несколько примеров, говорящих о том, с какими бешеными темпами генерируются новые данные.

Многообразие. Понятие «большие данные» распространяется не только на буквы и цифры: он включает в себя аудио, видео, разрозненный текст, данные из соцсетей и многое другое. И там, где одни видят гигантскую свалку ненужных сведений, другие видят бесценный актив, способный изменить мир.

Термин Big Data впервые был введен главой компании O’Reilly Роджером Мугалусом еще в 2005 году. Однако вопросом о том, как обрабатывать доступные данные, начали задаваться очень давно. На самом деле первые записи о попытках использовать данные для управления деятельностью предприятий имеют возраст, превышающий 7000 лет.

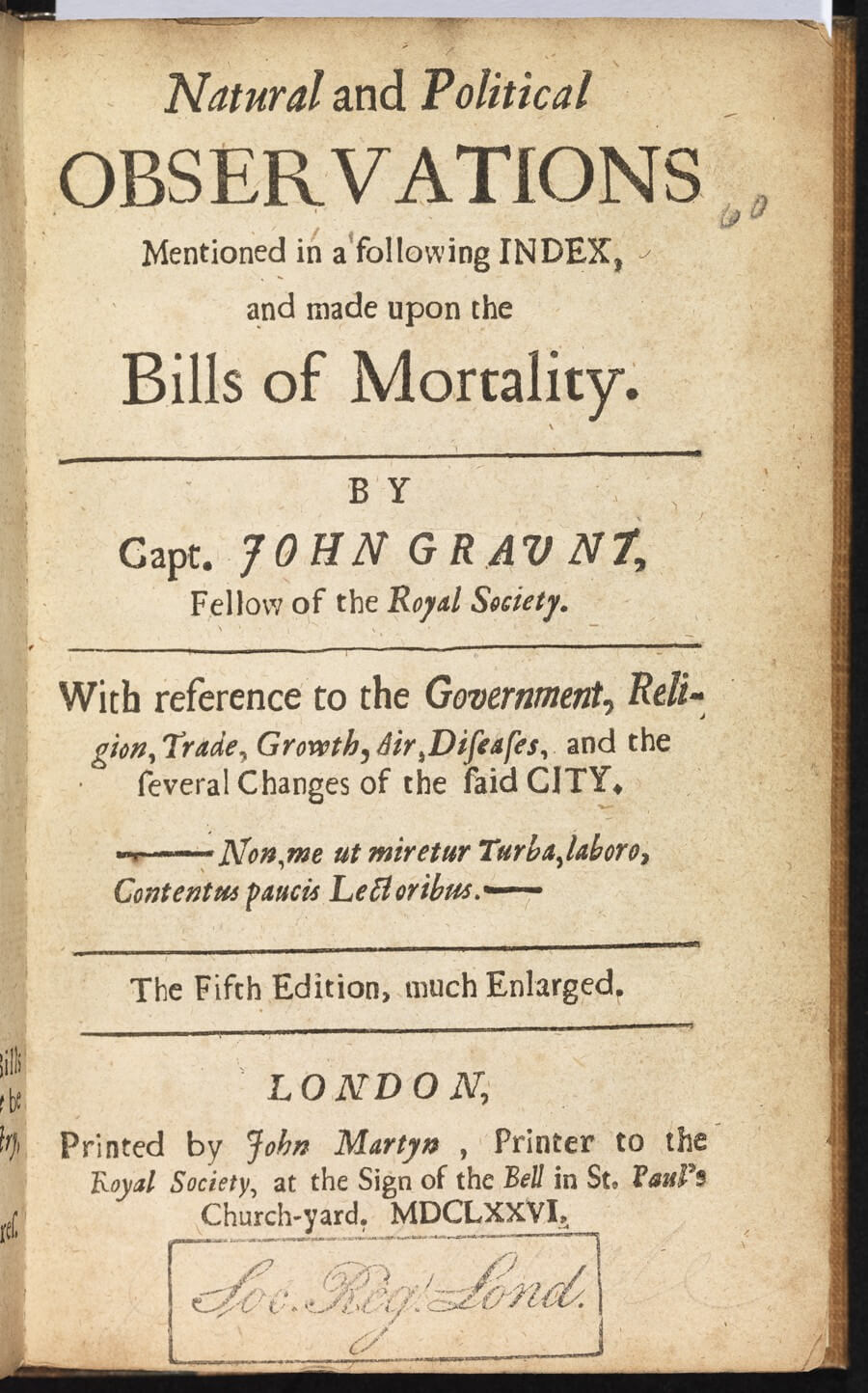

Именно в те времена в Месопотамии начали вести учет сбора урожаев и разведения скота. Принципы учета продолжали эволюционировать и улучшаться, и в 1663 году демограф Джон Граунт начал фиксировать и анализировать показатели смертности в Лондоне. Делал он это для того, чтобы общественность оценила масштабы распространения бубонной чумы в те времена.

В своей книге «Естественные и политические наблюдения над списками умерших» Граунт подарил миру первый в истории статистический анализ данных. Книга позволила пролить свет на основные причины смертей в Англии 17-го века. Благодаря этой работе Граунт прославился как первопроходец в сфере статистики.

С тех времен принципы учета данных продолжили улучшаться, но ничего экстраординарного в этом направлении не возникло до тех пор, пока конец 19-го века не возвестил о вступлении в информационную эру. Новая эпоха началась в 1889 году, когда Герман Холлерит изобрел вычислительную систему для сортировки данных переписи населения.

Следующий заметный скачок произошел в 1937 году, когда пост президента США занимал Франклин Рузвельт. После того как в Конгрессе был принят Закон о государственной безопасности, от правительства потребовали вести учет миллионов американцев. В итоге правительство обратилось к компании IBM с просьбой разработать систему считывания перфокарт, которые были призваны хранить огромные объемы данных.

Однако первой машиной для обработки данных принято считать систему «Колосс», которая была разработана британцами в 1943 году для расшифровки кодов нацистов во время Второй мировой войны. Машина занималась поиском любых паттернов, которые регулярно появлялись в перехваченных сообщениях. Система работала с рекордной скоростью и смогла обрабатывать 5000 знаков в секунду, что позволяло за пару часов выполнять работу, на которую раньше уходили недели.

Первый дата-центр был учрежден американским правительством в 1965 году и был предназначен для хранения миллионов отпечатков пальцев и записей об уплаченных налогах. Записи фиксировались на магнитных лентах, которые систематизировались и хранились в специальном помещении. Считается, что это было первым электронным хранилищем информации.

В 1989 году британский специалист по информатике Тим Бернерс-Ли изобрел всемирную компьютерную сеть, задавшись целью обеспечить обмен информацией посредством гипертекстовой системы. Тогда он даже представить не мог, какое влияние на мир окажет его изобретение, впоследствии получившее название «Интернет». После начала девяностых все больше устройств начало подключаться к глобальной сети, а значит, темпы генерирования данных стали расти еще активней.

В 1995 году был создан первый суперкомпьютер. Эта машина была способна за секунды выполнять работу, на которую у простого человека потребовались бы тысячи лет. А потом наступил 21 век.

Здесь мы вновь обратимся к 2005 году, когда Роджер Мугалус ввел термин «большие данные». В этом же году компания Yahoo создала ныне открытую платформу Hadoop, цель которой состояла в индексировании всего Интернета. Сегодня Hadoop используется миллионами предприятий для получения и обработки колоссальных объемов данных.

За последние 10 лет социальные сети стремительно развивались, а объемы информации, создаваемой пользователями, ежедневно росли. Компании и правительства одно за другим начали реализацию проектов в сфере Big Data. Например, в 2009 году правительство Индии создало крупнейшую базу биометрических данных, в которой хранятся отпечатки пальцев и сканы радужных оболочек глаза всех граждан страны.

В 2010 году глава Google Эрик Шмидт выступил на калифорнийской конференции Techonomy, рассказав, что за последние семь лет компания накопила 5 эксабайт данных. Вряд ли он мог представить, что к 2017 году аналогичный объем информации будет вырабатываться ежедневно. При этом темпы роста и не думают замедляться.

Взгляд в прошлое позволил нам составить примерное представление о том, какие тенденции нас ждут в будущем. Если два десятилетия назад самыми успешными были предприятия, которые владеют информацией, то сегодня успех имеют те, кто умеют наилучшим образом интерпретировать и использовать имеющуюся информацию. Вполне логично можно ожидать, что в будущем успех будет зависеть от способности заставить большие данные содействовать в принятии верных стратегических решений.

Наверняка у большинства из нас при упоминании понятия «большие данные» в голове возникает огромное помещение, заставленное множеством серверов с мигающими огоньками. Но чтобы понять, что речь идет о действительно важном феномене, изменившем правила игры, достаточно обратиться к нескольким примерам.

Недавние выборы президента США показали, насколько эффективным может оказаться применение новейших информационных технологий. В то время как Хиллари Клинтон прибегала к традиционным методам и привлекала в свой штаб знаменитостей, команда Дональда Трампа решила сфокусировать внимание на изучении предпочтений и потребительского поведения миллионов американцев. Получив точные данные о том, чего хочет электорат, штаб кандидата от республиканцев смог более эффективно отвечать на запросы активных пользователей Интернета. В итоге победа Трампа не выглядит такой уж неожиданной, если принять во внимание то, какая большая и результативная работа была проделана.

Или возьмем, к примеру, стриминг-сервис Netflix, который за последние годы стал одним из самых популярных производителей контента. Поставляя видеоматериалы зрителям, компания успела накопить гигантский объем статистических данных, досконально изучив предпочтения пользователей: какие сюжеты им больше по душе, каких актеров они любят, какие сцены пересматривают несколько раз, а какие пропускают. В итоге каждый новый сериал Netflix попадает в точку и зарабатывает самые высокие рейтинги на IMDB. Если вы по-прежнему считаете, что залог успеха состоит в таланте шоураннеров, то, скорее всего, вы слишком наивны.

В микроскопическом масштабе большие данные можно поставить на службу вашему самосовершенствованию. Например, ваш фитнес-браслет или умные часы может собирать информацию о потребляемых калориях, пройденном расстоянии, сердечном пульсе, а также статистику сна. Сбор и анализ таких сведений позволит вам скорректировать свои привычки, что при должном терпении должно будет позитивно сказаться на вашем здоровье и долголетии.

Кстати, и в глобальном масштабе большие данные активно помогают медицине. Уже сейчас обработка накопленных статистических данных позволяет не только в считанные минуты с высокой точностью диагностировать различные заболевания, но и эффективно прогнозировать их возникновения. Это должно будет обезопасить людей от затаившейся угрозы и спасти миллионы жизней.

Один из ярких тому примеров — платформа ResearchKit, которую компания Apple запустила в 2016 году. Благодаря использованию мобильных приложений медицинские специалисты собирают данные о состоянии здоровья пользователей. Это позволяет не только распространять уход за больными за пределы клиники и обеспечивать их скорейшее выздоровление, но и накапливать необходимые данные для повышения эффективности взаимодействия с будущими пациентами.

Разумеется, большими данными активно пользуются и правоохранительные органы. Например, Агентство национальной безопасности США использует имеющимися данными для выявления и предупреждения террористической активности. Корпорации давно пользуются решениями в этой области для профилактики кибератак и несанкционированных проникновений в системы. Полиция тоже экспериментирует с Big Data, пытаясь на основании информации из публичных профилей определять потенциальную угрозу для правопорядка того или иного гражданина.

Здесь нелишним будет вспомнить показательную историю 2014 года, когда чикагская полиция при помощи компьютерной системы составила список из 400 жителей города, которые имеют все предпосылки для того, чтобы нарушить закон. Полицейские посетили этих граждан и провели с ними профилактические беседы, однако история наделала много шума, в первую очередь из-за бесцеремонного вторжения в личную жизнь. Хотя проект со скандалом закрыли, нет никаких свидетельств того, что компьютерный анализ потенциальных криминальных наклонностей граждан был прекращен.

Хотя эпоха больших данных все еще находится на начальной стадии, достижениями этой дисциплины уже активно пользуются как частные корпорации, так и правительства. Но главное, чтобы этот ценный актив не оказался в распоряжении тех, кто мог бы использовать его во вред человечеству.

#тренды | Нейросети

Источник: